怎么在Windows操作系统部署阿里开源版通义千问(Qwen2)

- 工作小总结

- 时间:2024-09-01 18:58

- 395人已阅读

🔔🔔🔔好消息!好消息!🔔🔔🔔

有需要的朋友👉:联系凯哥

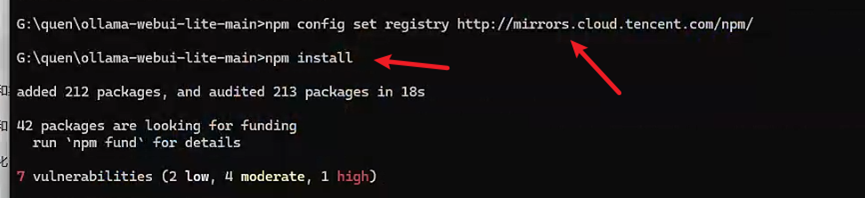

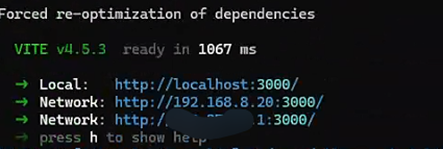

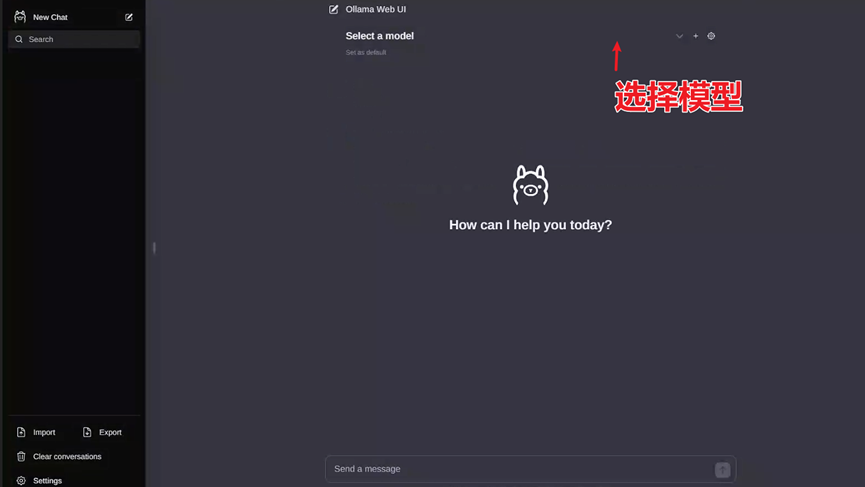

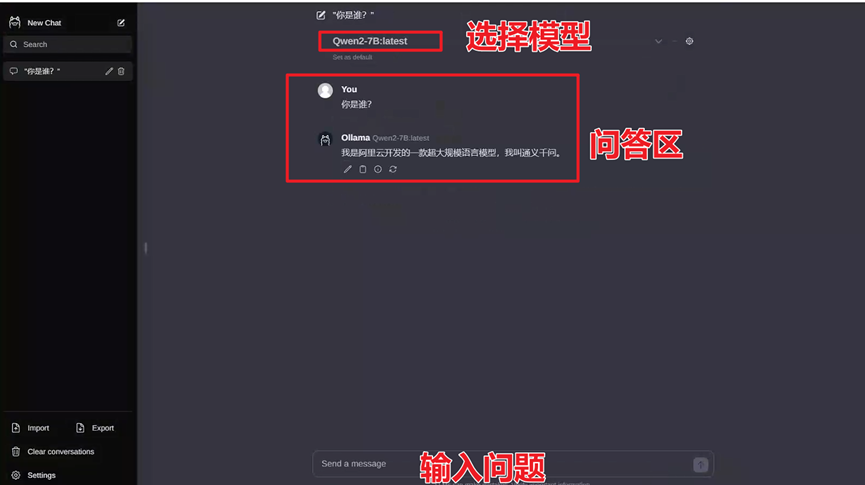

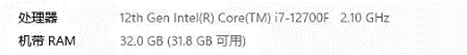

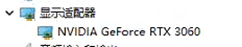

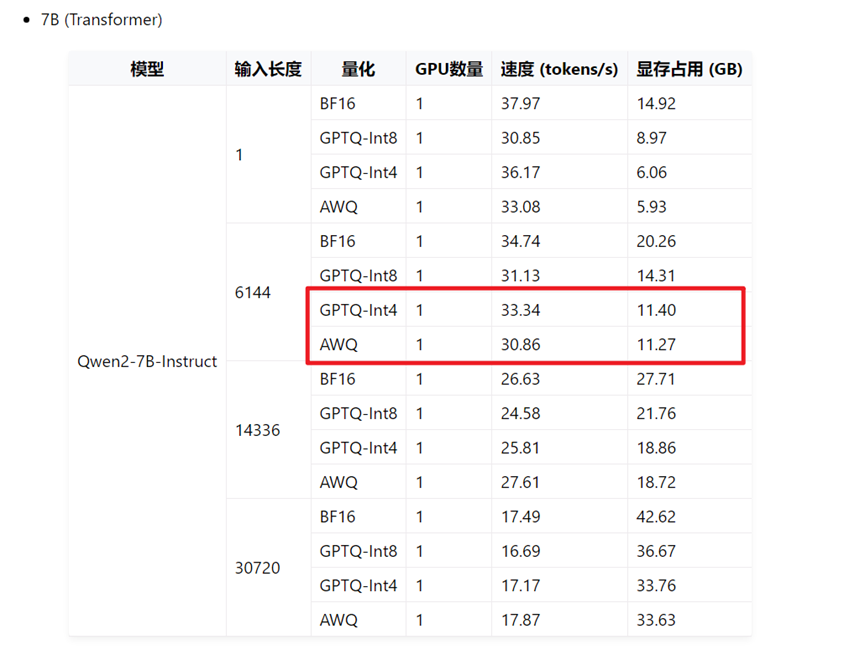

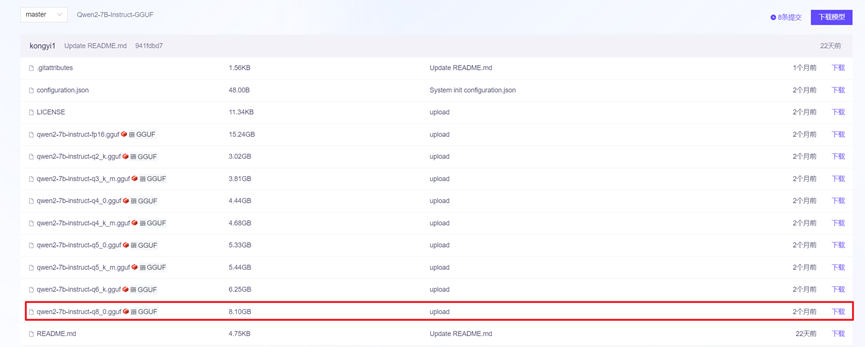

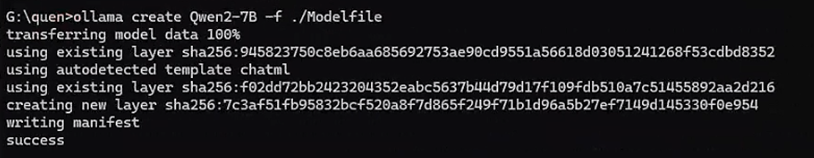

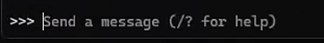

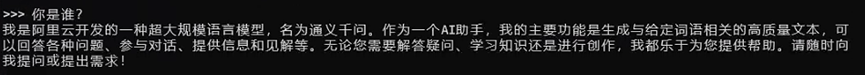

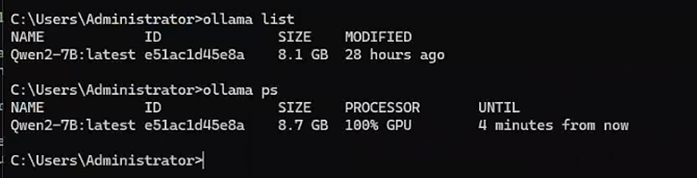

怎么在Windows操作系统部署阿里开源版通义千问(Qwen2) | 原创作者/编辑:凯哥Java | 分类:人工智能学习系列教程 GitHub上qwen2截图 随着人工智能技术的不断进步,阿里巴巴通义千问团队近期发布了Qwen2系列开源模型,这一系列模型在多个领域展现出卓越的性能,特别是在自然语言理解、知识、代码、数学及多语言等能力上均显著超越当前领先的模型。本文将详细介绍如何在Windows操作系统上部署阿里开源版通义千问(Qwen2)模型,快速上手并体验这一强大的AI工具。 1. 系统兼容性:确保您的Windows系统版本支持所需的软件安装。 2. 显卡驱动:如果您的计算机配备了独立显卡,请确保显卡驱动是最新的,以便更好地支持模型运行。 3. 硬盘空间:Qwen2模型文件较大,需要足够的硬盘空间来存储。 凯哥使用的电脑配置: CPU:I7-12700F 内存:32GB 显卡:RTX3060 12G cpu和内存 显卡 访问Ollama官网:进入Ollama官网(https://ollama.com/download/windows)。 2. 下载并安装:点击“Download”按钮,选择Windows版本进行下载。下载完成后,按照提示进行安装。 这里凯哥就选择Windows版本的。 ollama官网下载页面 1. 访问官方教程:访问Qwen2官方教程(实际链接以官方提供为准)。 https://qwen.readthedocs.io/zh-cn/latest/ 2. 选择适合的模型:根据您的硬件条件(如显卡显存大小),选择适合的Qwen2模型版本。在官方教程中,拉到最下面,可以看到效率评估。如下图: 找到效率评估 因为凯哥的显卡是12GB,所以凯哥选择Qwen2-7B-Instruct。如果你的显卡也是12GB,可以选择Qwen2-7B-Instruct版本。 Qwen2-7B-Instruct不同版本内存占用 凯哥使用的下载地址:https://modelscope.cn/models/qwen/Qwen2-7B-Instruct-GGUF/files 3. 下载模型文件:在官方教程中,找到模型下载链接,下载对应的.gguf文件。注意,模型文件可能包含多个精度版本(如q8、q16等),选择适合您需求的版本。 说明: 会看到不同的后缀,q”+ 用于存储权重的位数(精度)+ 特定变体,数字越大性能越强。 数字越大,精度越高,k是在所有的attention和feed_forward张量上将精度提升2位,m是在一半的attention和feed_forward张量上将精度提升2位。 根据自己的需求选择模型,凯哥这里直接选了q8。 凯哥选择的q8 1. 创建模型文件:在Windows上创建一个新文件夹(例如命名为“qwen”),将下载的.gguf文件放入该文件夹中。然后,在该文件夹内创建一个名为“Modelfile”的文本文件,内容填写为: 注意替换文件名以匹配您下载的模型文件。 2. 使用Ollama创建模型:打开命令行工具(如CMD或PowerShell),切换到包含Modelfile的文件夹。运行以下命令来创建Qwen2模型: 模型创建成功 如果显示“success”,则表示模型创建成功。 3. 运行模型:创建成功后,您可以通过以下命令来运行模型: 此时,您应该能看到一个对话框或命令行界面,您可以在这里输入文本与模型进行交互。 命令行输入文案地方 在这里输入:你是谁?看看模型怎么交互的。 可以看到模型交互如下: 模型交互效果 补充说明: 如果要删除这个模型的话:ollama rm xxx 如果要看运行了哪些大模型:ollama ps 运行结果: 运行效果 1. 安装Node.js: 首先,需要在Windows上安装Node.js。访问Node.js官网,下载并安装最新版本的Node.js。 凯哥使用的是版本号是18.6 凯哥本地node版本 2. 下载ollama-webui: 从GitHub或其他源下载ollama-webui的代码。 3. 设置并启动Web界面: 按照ollama-webui的文档说明,设置Node.js环境,安装依赖,并启动Web服务器。然后,在浏览器中打开Web页面,选择您的Qwen2模型即可开始对话。 3.1镜像提速: 入ollama-webui文件夹,设置国内镜像源提速: 3.2 安装依赖 错误解决办法: 如果报错说要audit,则依次进行即可: 启动 3.3 启动Web界面: 命令执行完成就可以用看到如下图的访问地址: 启动成功输出访问地址 打开Web页面,选择你的模型即可开始对话: 访问页面 通过web和模型进行交互: 我们依然输入:你是谁? 在web也没和模型交互效果 好了,至此,你就可以在自己电脑上和模型进行对话了。 大家好:我是凯哥Java(kaigejava),如果大家感兴趣,可以一起学学AI。 通过以上步骤,您可以在Windows操作系统上成功部署阿里开源版通义千问(Qwen2)模型,并通过命令行或Web界面与模型进行交互。Qwen2系列模型凭借其卓越的性能和广泛的应用场景,将为您的AI项目提供强大的支持。 希望本文能帮助您顺利部署阿里开源版通义千问模型,享受AI技术带来的便利与乐趣。如有任何疑问,请随时查阅官方文档或寻求技术支持。

在开始部署之前,请确保您的Windows系统满足以下要求:

Ollama是一个用于运行大型AI模型的工具,支持多种模型格式,包括Qwen2。首先,您需要从Ollama的官方网站下载并安装Ollama。

接下来,您需要从阿里通义千问的官方仓库下载Qwen2模型。

下载完模型文件后,您可以使用Ollama来部署Qwen2模型。

FROM ./qwen2-7b-instruct-q8_0.gguf

ollama run Qwen2-7B

如果要看本地有哪些大模型:ollama list

虽然直接在命令行中运行模型很方便,但为了获得更好的用户体验,您可以将Qwen2模型集成到Web界面中。

https://github.com/ollama-webui/ollama-webui-lite

npm config set registry http://mirrors.cloud.tencent.com/npm/

npm install

npm audit

npm audit fix